大型语言模型与硬编码秘密的风险

关键要点

大型语言模型LLMs为多个领域带来了重大的技术进步,包括代码生成,但也存在安全隐患。硬编码秘密如API密钥和数据库凭证直接嵌入源代码中,极易被黑客利用。使用秘密管理工具可以有效降低硬编码的风险。LLM的训练数据可能导致生成含有硬编码秘密的代码,因此需要采取措施来减少这一风险。如今,大型语言模型LLMs在许多领域如代码生成中推动了诸多突破性进展,这是不可否认的。然而,这些机器学习创新并非没有内在风险。我们已经了解到,这些模型可能生成带有硬编码秘密的代码,比如API密钥或数据库凭证。这种做法与推荐的秘密管理方式通过秘密管理工具显然形成鲜明对比。

了解硬编码秘密

硬编码秘密是指直接嵌入在源代码中的敏感数据,包括数据库凭证、API 密钥、加密密钥和其他类型的私人信息。虽然这种存储和访问数据的方法看起来很方便,但却带来了显著的安全风险。

如果这些代码落入不法之手,秘密将被暴露,攻击者可能会破坏相关服务。此外,在需要更换密钥或更改密码的情况下,硬编码秘密可能会导致问题。这需要修改代码本身,重新编译并重新部署应用程序。

LLM的角色

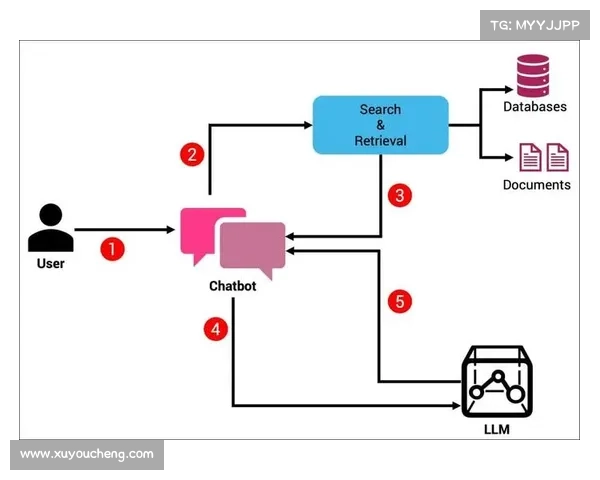

如ChatGPT4等大型语言模型表现出了根据给定提示生成代码片段的出色能力。尽管它们旨在理解上下文并生成符合最佳实践的代码,但由于训练数据的特性,它们可能偶尔会生成带有硬编码秘密的代码。

例如,如果训练数据包括许多含有硬编码秘密的代码片段,LLM可能会复制这一模式。需要注意的是,模型并不自然理解“秘密”的概念或其安全影响,它仅仅是模仿在训练过程中观察到的模式。

文档对LLM的影响

ChatGPT4的训练数据范围广泛,可能包括公开代码仓库、技术博客、论坛以及重要的文档。当这些模型在训练数据中遇到重复的模式如代码片段中的硬编码秘密时,它们会学习复制这些模式。LLM生成的代码反映了它们在训练中“见过”的内容。因此,如果训练数据中包含硬编码秘密的示例,LLM很可能会生成类似代码。

虽然在示例代码中硬编码秘密更简单,但文档编写者需要在简洁性与负责任的编码实践之间取得平衡。有可能添加免责声明,指明代码仅用于说明目的,且在实际应用中,我们应当绝不硬编码秘密。

然而,更重要的是,如果文档能提供如何使用秘密管理工具或环境变量处理敏感数据的示例,将会更好。这样,读者从一开始就能学习如何应用最佳实践,而以这些示例训练的LLM将生成更安全的代码。

快喵加速器ios手机版秘密管理的重要性

秘密管理是指安全存储、管理和访问敏感数据如API密钥、密码和令牌的过程。像HashiCorp Vault、AWS Secrets Manager或Azure Key Vault等秘密管理工具提供了更安全、更可扩展的秘密处理方式。它们通常具备自动加密、访问控制、审计和秘密轮换等功能。

通过使用秘密管理工具,敏感数据不会嵌入在代码中,从而降低了暴露秘密的风险。此外,当需要更改秘密值时,开发人员可以直接在秘密管理工具中进行,而无需触及代码库。

降低风险的策略

以下是几种降低LLM生成代码中硬编码秘密风险的策略:

后生成审查:对生成的代码进行全面审查。应手动检查硬编码秘密,并使用自动化工具扫描潜在问题。训练数据清理:如果可能,清理训练数据以剔除包含硬编码秘密的代码片段,从而降低LLM复制这一不安全